Mit seinen NVIDIA In-Network Computing- und In-Network Memory-Funktionen verlagert ConnectX-6 die Berechnungen noch weiter in das Netzwerk, wodurch CPU-Zyklen eingespart und die Netzwerkeffizienz erhöht werden. ConnectX-6 nutzt die RDMA-Technologie (Remote Direct Memory Access), die in der IBTA-Spezifikation (InfiniBand Trade Association) definiert ist, und sorgt so für niedrige Latenzzeiten und hohe Leistung. ConnectX-6 verbessert die RDMA-Netzwerkfähigkeiten sogar noch weiter, indem es eine End-to-End-Flusskontrolle auf Paketebene bietet.

Maschinelles Lernen und Big Data-Umgebungen

Die Datenanalyse ist in vielen Unternehmensrechenzentren, Clouds und Hyperscale-Plattformen zu einer wesentlichen Funktion geworden. Das maschinelle Lernen (ML) ist auf einen besonders hohen Durchsatz und niedrige Latenzzeiten angewiesen, um tiefe neuronale Netzwerke zu trainieren und die Erkennungs- und Klassifizierungsgenauigkeit zu verbessern. Mit seinem Durchsatz von 100 Gbit/s ist ConnectX-6 eine hervorragende Lösung, um ML-Anwendungen die erforderliche Leistung und Skalierbarkeit zu bieten.

Sicherheit einschließlich Verschlüsselung auf Blockebene

Die Block-Level-Verschlüsselung von ConnectX-6 stellt eine entscheidende Innovation für die Netzwerksicherheit dar. Bei der Speicherung oder dem Abruf von Daten im Transit werden diese ver- und entschlüsselt. Die ConnectX-6-Hardware entlastet die CPU von der IEEE AES-XTS-Verschlüsselung/Entschlüsselung und spart so Latenzzeit und CPU-Auslastung. Durch die Verwendung von dedizierten Verschlüsselungsschlüsseln wird außerdem der Schutz von Benutzern gewährleistet, die dieselben Ressourcen nutzen. Durch die Verschlüsselung des Blockspeichers im Adapter macht der ConnectX-6 selbstverschlüsselte Festplatten überflüssig. Dies gibt Kunden die Freiheit, ihr bevorzugtes Speichergerät zu wählen, einschließlich byteadressierbarer und NVDIMM-Geräte, die traditionell keine Verschlüsselung bieten. Darüber hinaus kann ConnectX-6 die Einhaltung der Federal Information Processing Standards (FIPS) gewährleisten.

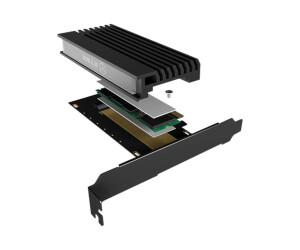

Einführung von NVMe-oF in Speicherumgebungen

NVMe-Speichergeräte sind auf dem Vormarsch und bieten einen sehr schnellen Zugriff auf Speichermedien. Das sich entwickelnde NVMe-over-Fabrics (NVMe-oF)-Protokoll nutzt RDMA-Konnektivität für den effizienten Fernzugriff auf NVMe-Speichergeräte, während das End-to-End-NVMe-Modell eine geringe Latenz aufweist. Mit seinen NVMe-oF-Ziel- und Initiator-Offloads sorgt ConnectX-6 für eine weitere Optimierung von NVMe-oF und verbessert die CPU-Auslastung und Skalierbarkeit.

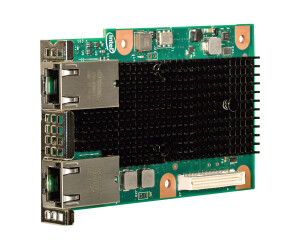

NVIDIA Socket Direct

ConnectX-6 bietet auch Optionen für NVIDIA Socket Direct-Konfigurationen, die die Leistung von Multi-Socket-Servern verbessern, indem jede CPU über ihre dedizierte PCIe-Schnittstelle auf das Netzwerk zugreifen kann. Dadurch können die Daten das QPI (UPI) und die andere CPU umgehen, was die Latenz, die Leistung und die CPU-Auslastung verbessert. Socket Direct ermöglicht auch NVIDIA GPU Direct RDMA für alle CPU/GPU-Paare, indem sichergestellt wird, dass die GPUs mit den CPUs in der Nähe der Adapterkarte verbunden sind. Socket Direct ermöglicht die Intel DDIO-Optimierung auf beiden Sockeln, indem eine direkte Verbindung zwischen den Sockeln und der Adapterkarte hergestellt wird. Die Socket Direct-Technologie wird durch eine Hauptkarte, die den ConnectX-6 beherbergt, und eine zusätzliche PCIe-Karte, die die restlichen PCIe-Lanes bereitstellt, ermöglicht. Die ConnectX-6 Socket Direct-Karte wird in zwei PCIe x16-Steckplätze eingebaut und mit einem Kabelbaum verbunden. Die beiden PCIe-x16-Steckplätze können auch an dieselbe CPU angeschlossen werden. In diesem Fall liegt der Hauptvorteil der Technologie in der Bereitstellung von 200 Gb/s für Server, die nur PCIe Gen3 unterstützen.

Host-Verwaltung

Das Host-Management umfasst NC-SI über MCTP über SMBus und MCTP über PCIe - Baseboard Management Controller (BMC)-Schnittstelle sowie PLDM für Monitor und Steuerung DSP0248 und PLDM für Firmware-Update DSP0267.

- Condition: Brand new, bulk

- Device Type: Netzwerkkarte

- Hard Disk type: NVMe

- : PCI