SK hynix beendet Entwicklung von HBM4 – Speicherrevolution für KI und HPC

SK hynix vollendet Entwicklung von HBM4 – Speicherrevolution für KI und HPC

Datum: September 2025 · Kategorie: Speichertechnologie, KI-Hardware

1. Ein Meilenstein für die Speicherbranche

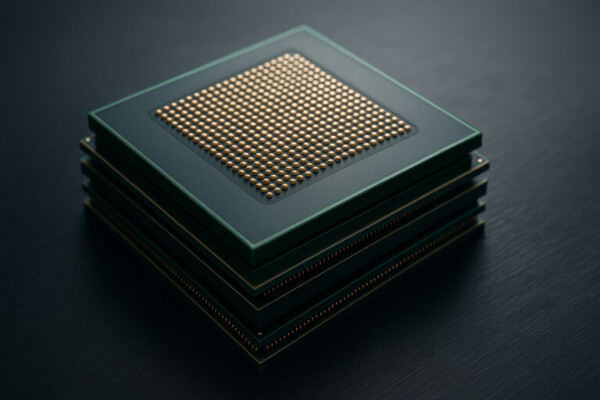

Der südkoreanische Hersteller SK hynix hat die Entwicklung von HBM4 offiziell abgeschlossen. High Bandwidth Memory (HBM) ist seit Jahren das Rückgrat leistungsstarker KI- und HPC-Systeme. Mit der vierten Generation erreicht die Technologie ein neues Level: breitere Interfaces, schnellere Übertragungen und eine drastisch verbesserte Energieeffizienz.

2. Ein Blick zurück: Von HBM1 zu HBM4

HBM wurde erstmals 2015 in AMDs Radeon Fury X eingesetzt. Seitdem entwickelte sich die Technologie sprunghaft:

- HBM1 (2015): 4-Stack-Design, ~128 GB/s Bandbreite pro Stack.

- HBM2 (2017): Bis zu 256 GB/s, erstmals in Nvidia Tesla und AMD Vega eingesetzt.

- HBM3 (2021): ~819 GB/s, Standard in KI-Beschleunigern wie Nvidias A100.

- HBM3e (2023): ~1,2 TB/s, aktuell im Einsatz in Nvidia H200 und AMD MI300.

- HBM4 (2025): >2 TB/s pro Stack – ein Sprung von fast 100 % gegenüber HBM3e.

3. Technische Eckdaten von HBM4

- Interface: 2.048-bit (doppelt so breit wie HBM3e)

- Geschwindigkeit: bis zu 10 GT/s pro Pin

- Bandbreite: über 2 TB/s pro Stack

- Kapazität: bis zu 64 GB pro Package

- Energieeffizienz: 20–25 % besser als HBM3e

- Fertigung: im 1β-DRAM-Knoten von SK hynix

Mit diesen Werten wird HBM4 zum maßgeblichen Enabler für KI-Modelle der nächsten Generation.

4. TSVs und Chiplets – die Technik im Detail

HBM4 setzt auf gestapelte DRAM-Dies, die über Through-Silicon Vias (TSVs) miteinander verbunden sind. Dieses 3D-Packaging erlaubt extrem kurze Signalwege und damit geringere Latenzen. Im Zusammenspiel mit modernen Chiplet-Architekturen wird HBM4 direkt neben GPU oder AI-Accelerator platziert, wodurch Datenraten von mehreren Terabyte pro Sekunde möglich sind.

5. Warum HBM4 für KI unverzichtbar ist

Große KI-Modelle wie GPT-5 oder Gemini 2 haben Billionen Parameter. Jede Inferenz und jedes Training benötigt Speicher mit enormer Bandbreite. Herkömmlicher DDR5 oder GDDR6X ist hier völlig überfordert. HBM4 liefert die Bandbreite und die Energieeffizienz, um solche Modelle realistisch betreiben zu können.

6. Nvidia, AMD und Intel – wer profitiert zuerst?

Alle großen Chipdesigner haben HBM4 bereits in ihren Roadmaps vorgesehen:

- Nvidia: Rubin-GPUs (2026) sollen auf HBM4 setzen.

- AMD: MI400-Serie, Nachfolger der MI300, wird mit HBM4 ausgestattet.

- Intel: Xe HPC (Falcon Shores) könnte HBM4 in Supercomputern nutzen.

Damit wird HBM4 ab 2026 zum Standard in High-End-Beschleunigern.

7. Einsatzgebiete über KI hinaus

HBM4 ist nicht nur für KI relevant. Auch Wettermodelle, Genomforschung, Quantenchemie und Finanzsimulationen profitieren enorm. Viele dieser Felder benötigen Bandbreite mehr als rohe Rechenleistung – ein Bereich, in dem HBM traditionell glänzt.

8. Energie und Nachhaltigkeit

Rechenzentren stehen unter Druck: steigende Stromkosten, Nachhaltigkeitsziele und wachsende Anforderungen. HBM4 bietet hier einen Vorteil: mehr Leistung pro Watt. Im Vergleich zu GDDR6X verbraucht HBM4 weniger Energie bei höherer Bandbreite – ein entscheidender Faktor bei zehntausenden verbauten Modulen.

9. Markt und Wettbewerb

Der HBM-Markt ist hart umkämpft. SK hynix dominiert mit einem Marktanteil von über 50 %, gefolgt von Samsung und Micron. Mit HBM4 baut SK hynix seinen Vorsprung weiter aus. Analysten erwarten, dass die Nachfrage ab 2026 exponentiell steigt – angetrieben durch Nvidia, AMD und Hyperscaler wie Microsoft und Google.

10. Geopolitische Bedeutung

Speicher ist längst geopolitisch relevant. SK hynix und Samsung sitzen in Südkorea, Micron in den USA. Gefertigt wird in enger Kooperation mit TSMC in Taiwan. Angesichts des US-China-Chipkonflikts wird HBM4 zu einer Schlüsseltechnologie, die stark von politischen Rahmenbedingungen abhängt. Wer Zugang zu HBM4 hat, sichert sich einen Vorteil im globalen KI-Rennen.

11. Blick nach vorn: HBM4E und HBM5

Schon jetzt wird an HBM4E gearbeitet – einer optimierten Version mit bis zu 12 GT/s Geschwindigkeit. Langfristig wird auch HBM5 diskutiert, das Bandbreiten von über 3 TB/s pro Stack ermöglichen könnte. Die Entwicklung bleibt also dynamisch, und HBM4 ist nur der nächste Schritt auf einem steilen Pfad.

12. Fazit: Ohne HBM4 keine KI-Revolution

HBM4 ist mehr als nur eine neue Speichertechnologie – es ist der Treiber der kommenden KI-Generation. Ohne die enormen Bandbreiten und die bessere Energieeffizienz von HBM4 wären Modelle wie GPT-6 oder Gemini 3 nicht realisierbar. SK hynix setzt mit diesem Entwicklungsschritt ein klares Zeichen und festigt seine Position als globaler Technologieführer.